借助 DeepSeek R1 与 AnythingLLM 打造个人专属本地知识库

.gif)

AI-摘要

DeepSeek-V3 GPT

AI初始化中...

介绍自己 🙈

生成本文简介 👋

推荐相关文章 📖

前往主页 🏠

前往爱发电购买

借助 DeepSeek R1 与 AnythingLLM 打造个人专属本地知识库

ZETMAN使用DeepSeek R1 与 AnythingLLM 搭建本地知识库

一、安装Ollama

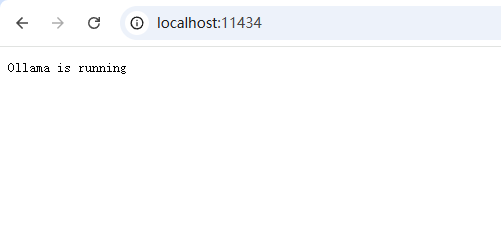

安装后浏览器访问

http://localhost:11434/出现 Ollama is running 提示表示安装成功

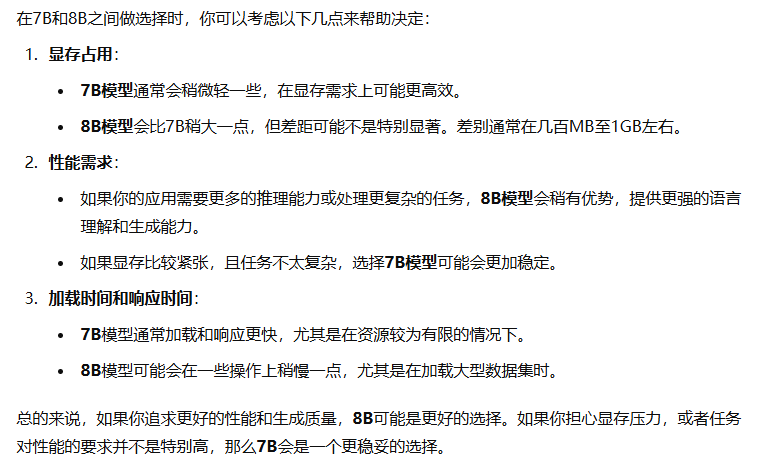

二、下载DeepSeek模型

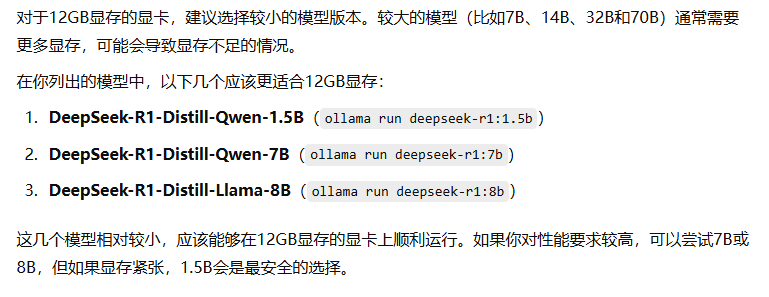

模型下载建议:显卡显存12G建议下载7B或者8B模型版本,7B:适合本地知识库,资源占用更低,性价比更高。命令行界面(cmd)输入下载对应的模型版本,如输入

ollama run deepseek-r1:7b命令。

1 | # DeepSeek-R1 |

- 详细建议

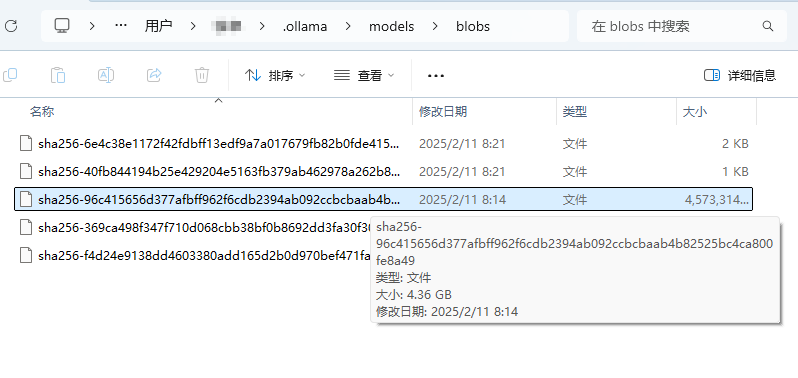

如果正常使用魔法下载速度过慢的话请耐心等待,或者参考文章底部参考链接中提供的解决办法。魔塔社区模型库 建议下载GGUF为后缀的模型文件。

默认模型路径:

C:\Users\<Username>\.ollama\models\blobs

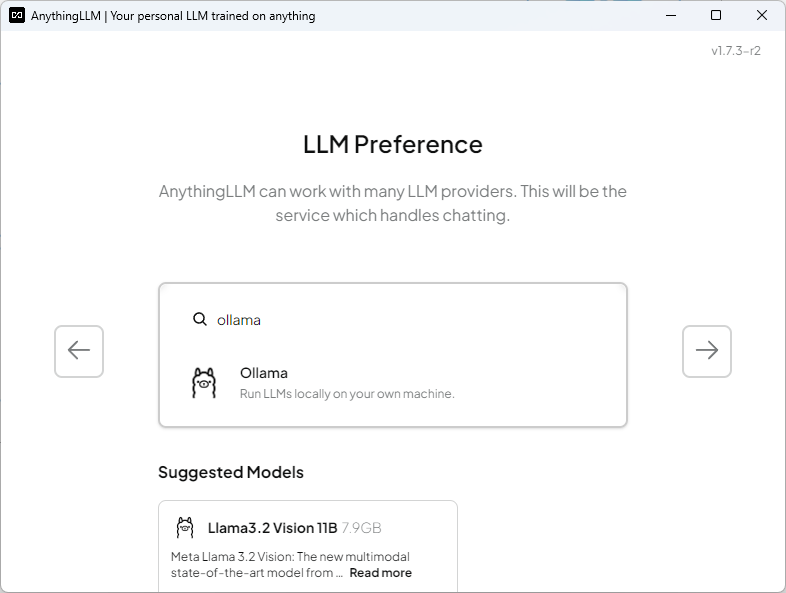

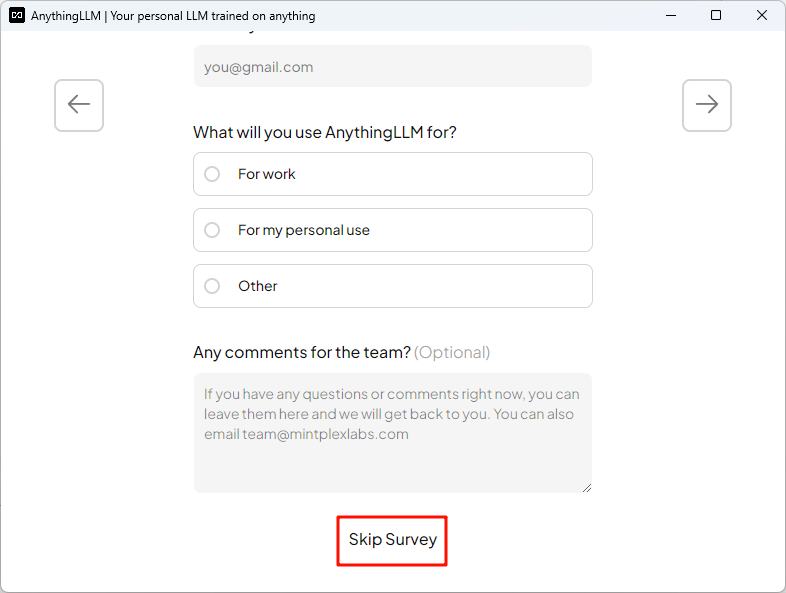

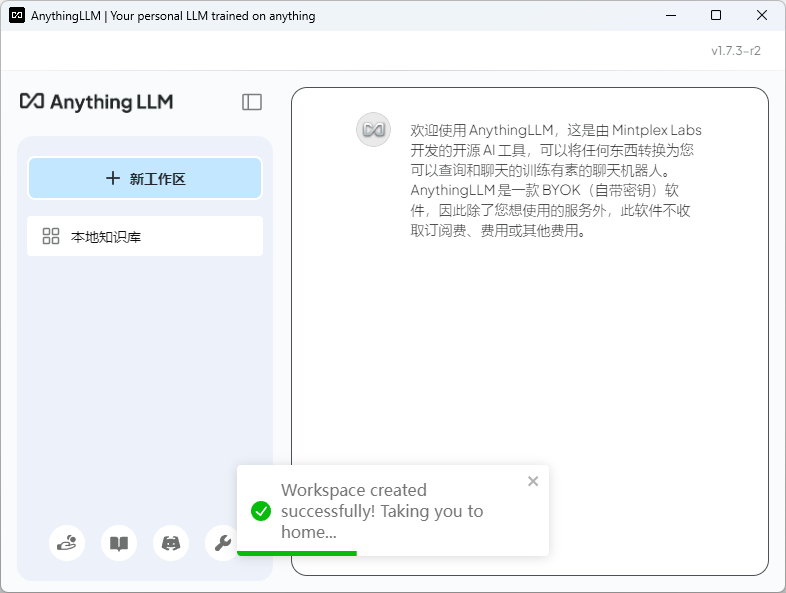

三、安装AnythingLLM

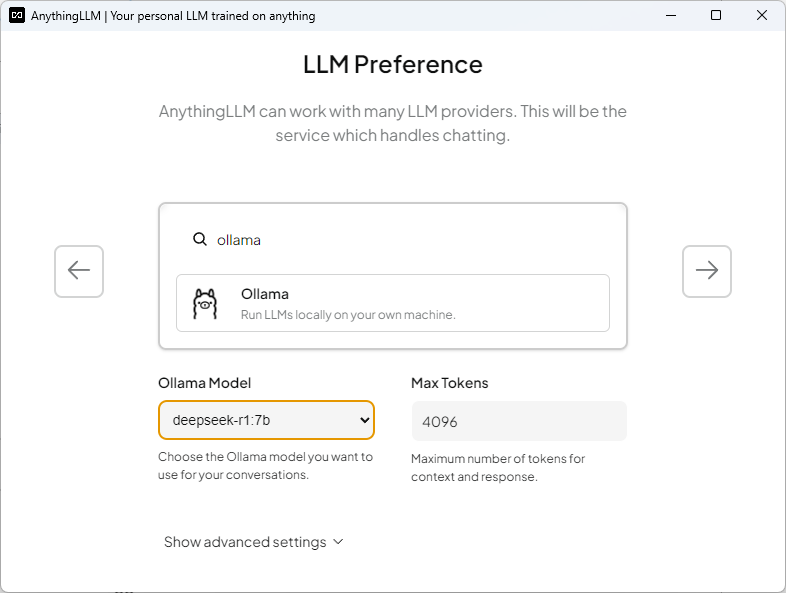

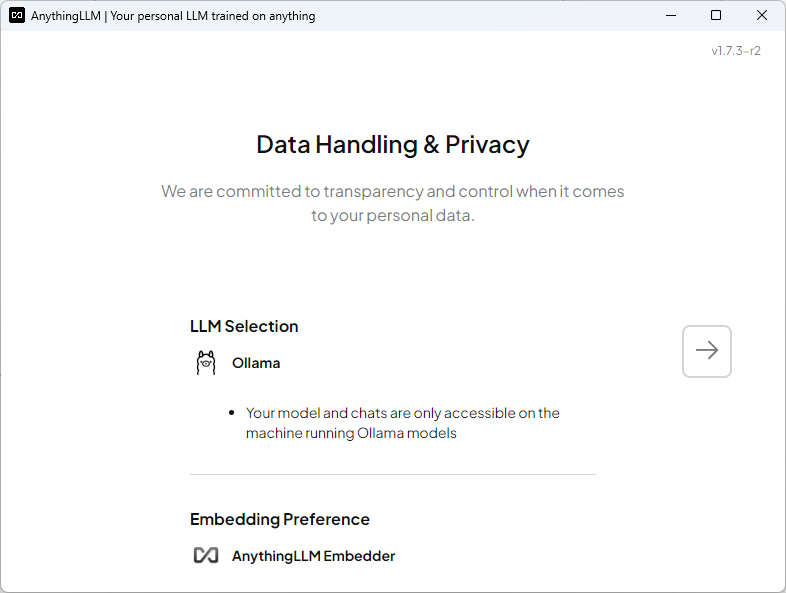

设置大模型

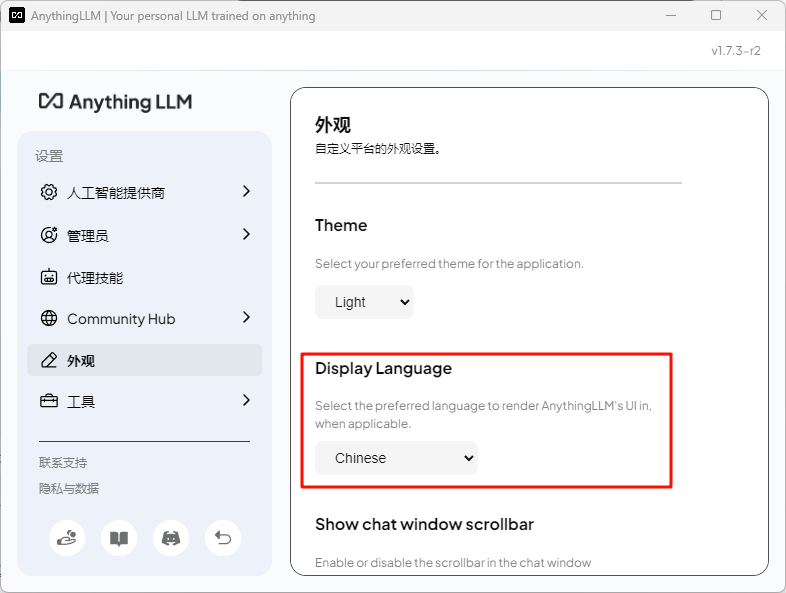

- 设置中文

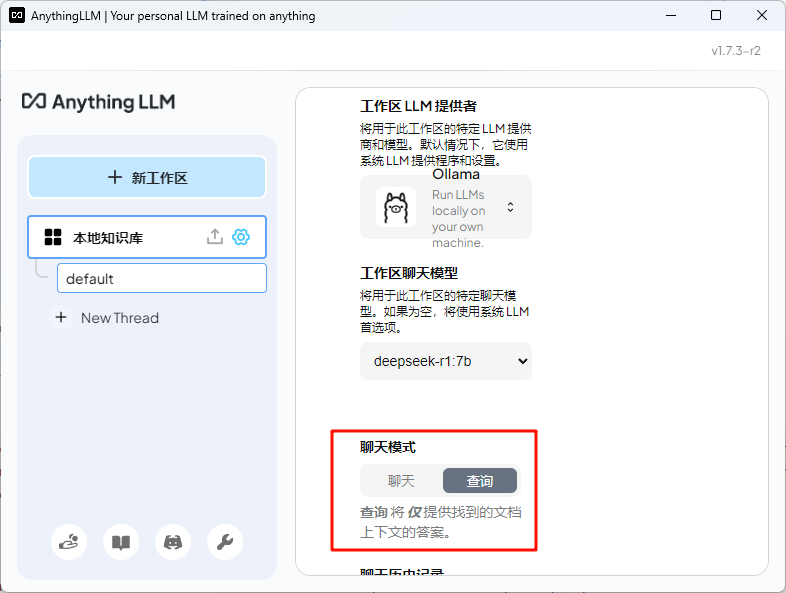

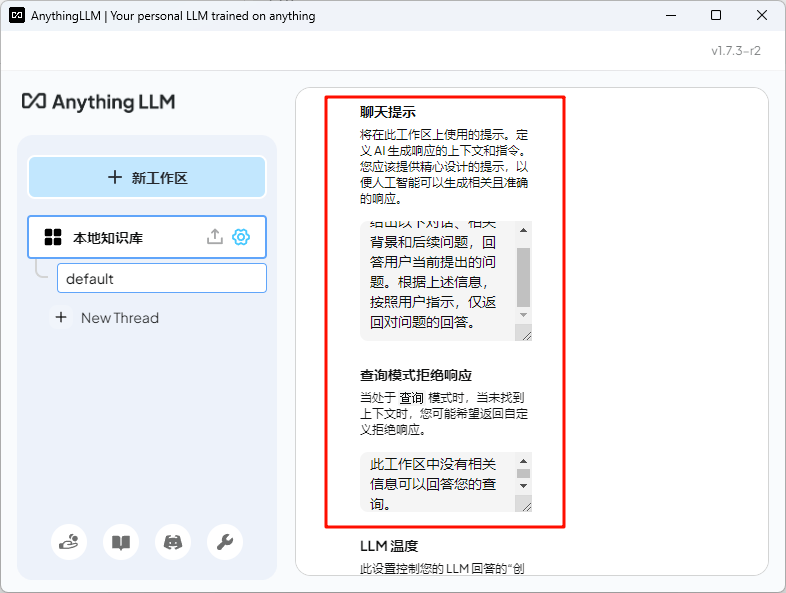

- 聊天设置(替换为中文)

1 | Given the following conversation, relevant context, and a follow up question, reply with an answer to the current question the user is asking. Return only your response to the question given the above information following the users instructions as needed. |

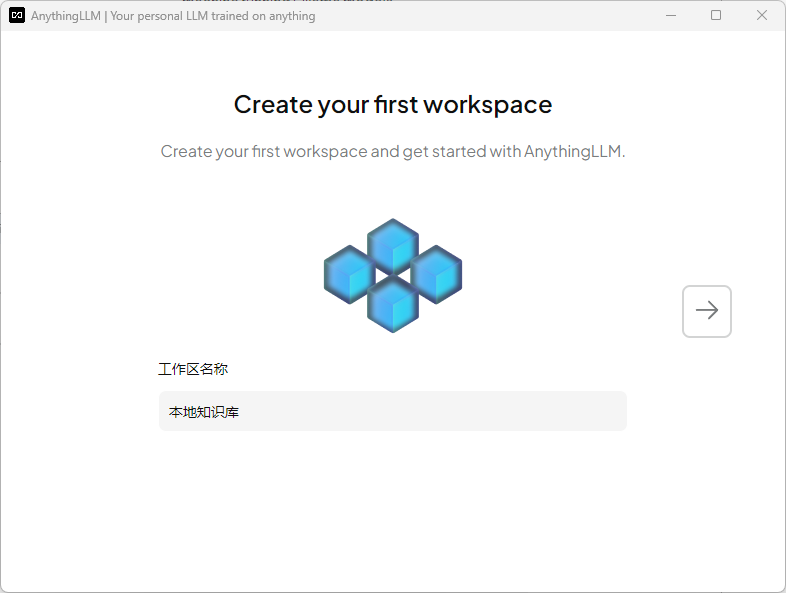

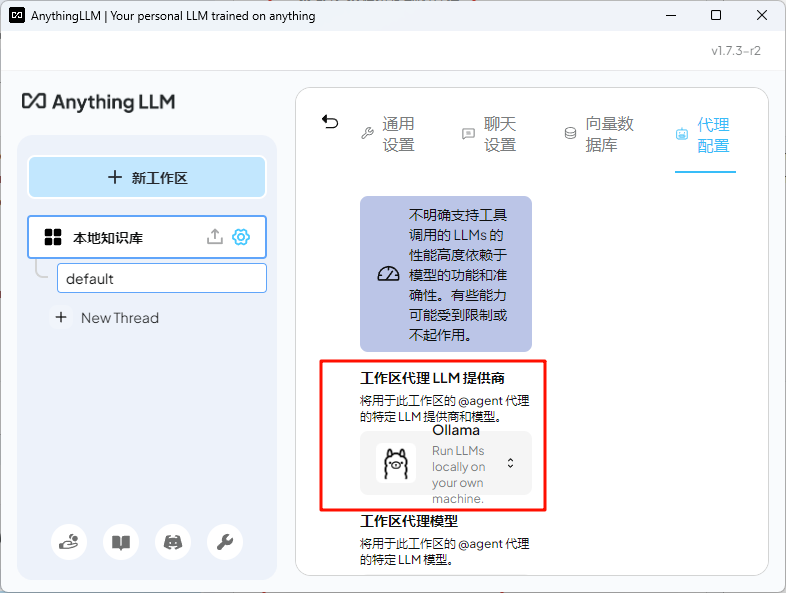

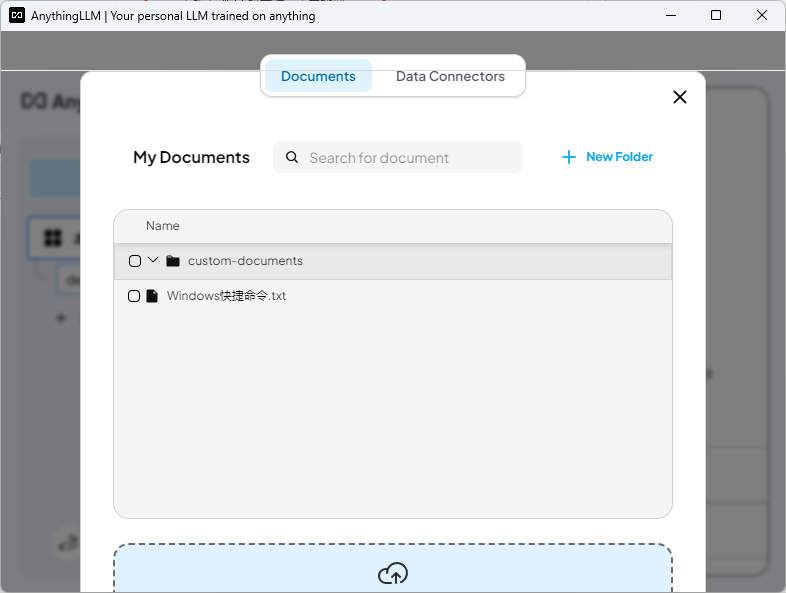

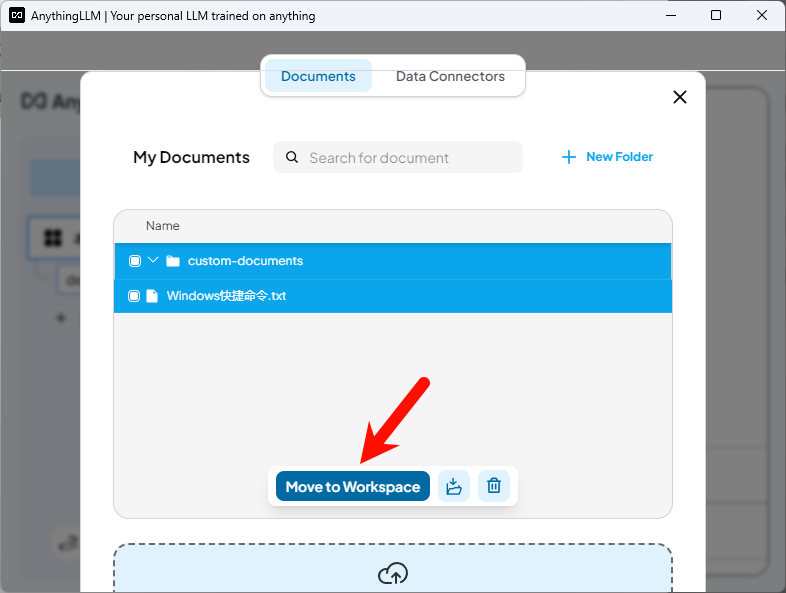

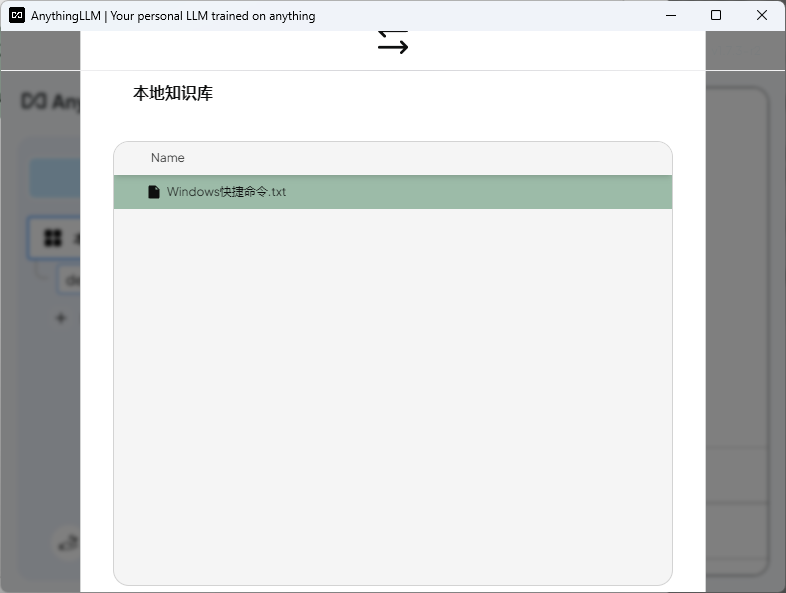

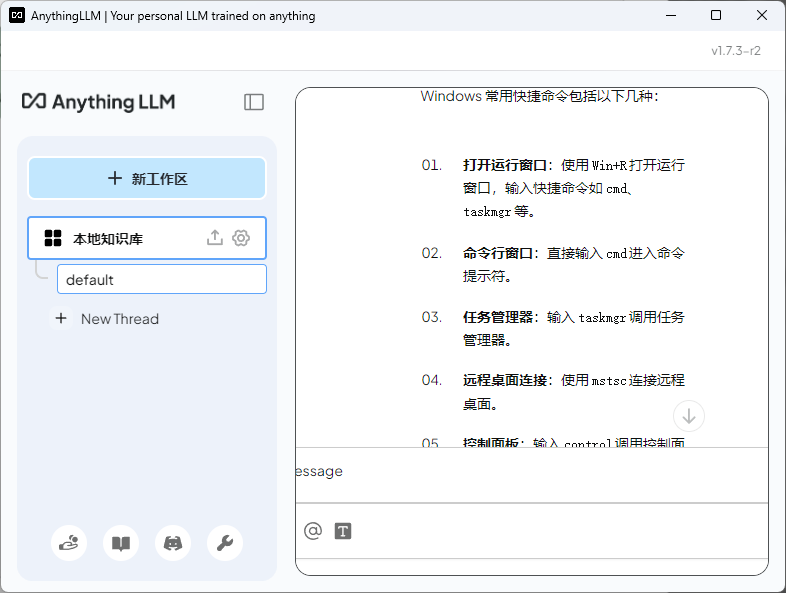

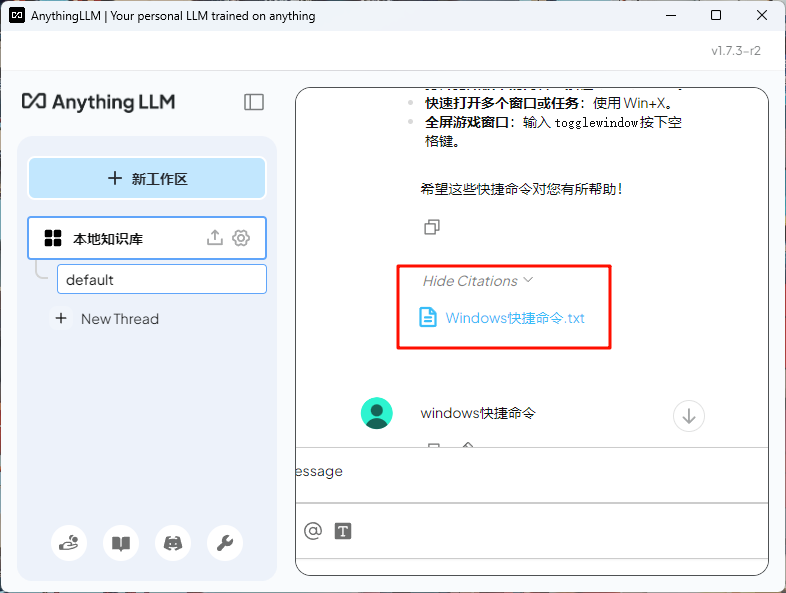

- 自定义本地知识库

- 问题测试(与文档内容一致)

四、参考链接

评论

匿名评论隐私政策

✅ 你无需删除空行,直接评论以获取最佳展示效果

.gif)

.gif)